Los chips portadores de luz hacen avanzar el aprendizaje de la máquina

En la era digital, el tráfico de datos está creciendo a un ritmo exponencial. Las demandas de potencia de computación para aplicaciones de inteligencia artificial, como el reconocimiento de patrones y del habla en particular, o para vehículos que se conducen por sí solos, suelen superar las capacidades de los procesadores informáticos convencionales. En colaboración con un equipo internacional, los investigadores de la Universidad de Münster están elaborando nuevos enfoques y arquitecturas de procesos que pueden hacer frente a esas tareas con gran eficacia. Han demostrado ahora que los denominados procesadores fotónicos, con los que se procesan los datos por medio de la luz, pueden procesar la información mucho más rápidamente y en paralelo, algo que los chips electrónicos son incapaces de hacer. Los resultados se han publicado en la revista "Nature".

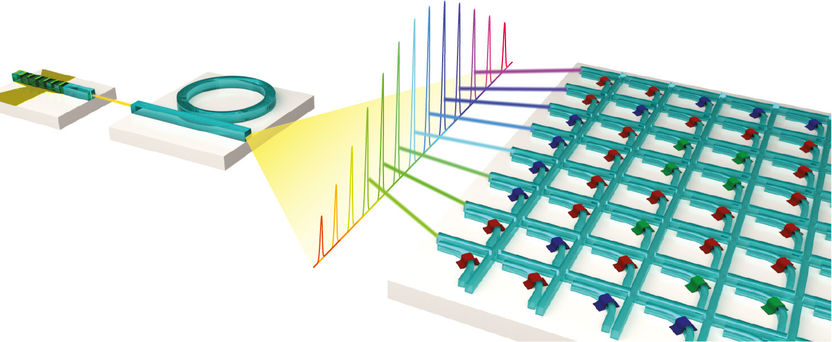

Representación esquemática de un procesador para multiplicaciones de matrices que funciona con luz. Junto con un peine de frecuencias ópticas, la matriz de barras transversales de guía de ondas permite un procesamiento de datos altamente paralelo.

Copyright: WWU/AG Pernice

Antecedentes y metodología

Los procesadores basados en la luz para acelerar las tareas en el campo del aprendizaje de las máquinas permiten procesar tareas matemáticas complejas a velocidades enormemente rápidas (10¹² -10¹⁵ operaciones por segundo). Los chips convencionales como las tarjetas gráficas o el hardware especializado como el TPU (Tensor Processing Unit) de Google se basan en la transferencia electrónica de datos y son mucho más lentos. El equipo de investigadores dirigido por el Prof. Wolfram Pernice del Instituto de Física y el Centro de Nanociencia Suave de la Universidad de Münster implementó un acelerador de hardware para las llamadas multiplicaciones de matriz, que representan la principal carga de procesamiento en el cómputo de las redes neuronales. Las redes neuronales son una serie de algoritmos que simulan el cerebro humano. Esto es útil, por ejemplo, para clasificar objetos en imágenes y para el reconocimiento del habla.

Los investigadores combinaron las estructuras fotónicas con materiales de cambio de fase (PCM) como elementos de almacenamiento de energía eficiente. Los PCM se utilizan normalmente con los DVD o discos BluRay en el almacenamiento óptico de datos. En el nuevo procesador esto hace posible almacenar y preservar los elementos de la matriz sin necesidad de un suministro de energía. Para llevar a cabo multiplicaciones de la matriz en múltiples conjuntos de datos en paralelo, los físicos de Münster utilizaron un peine de frecuencias basado en chips como fuente de luz. Un peine de frecuencias proporciona una variedad de longitudes de onda ópticas que se procesan independientemente unas de otras en el mismo chip fotónico. Como resultado, esto permite un procesamiento de datos altamente paralelo calculando en todas las longitudes de onda simultáneamente - también conocido como multiplexación de longitudes de onda. "Nuestro estudio es el primero en aplicar peines de frecuencia en el campo de las redes neuronales artificiales", dice Wolfram Pernice.

En el experimento los físicos utilizaron una llamada red neuronal convolutiva para el reconocimiento de números escritos a mano. Estas redes son un concepto en el campo del aprendizaje automático inspirado en los procesos biológicos. Se utilizan principalmente en el procesamiento de datos de imagen o de audio, ya que actualmente alcanzan las mayores precisiones de clasificación. "La operación convolutiva entre los datos de entrada y uno o más filtros -que puede ser un resaltado de bordes en una foto, por ejemplo- puede transferirse muy bien a nuestra arquitectura matricial", explica Johannes Feldmann, el autor principal del estudio. "La explotación de la luz para la transferencia de la señal permite al procesador realizar un procesamiento de datos en paralelo mediante la multiplexación de la longitud de onda, lo que conduce a una mayor densidad de computación y a que se realicen muchas multiplicaciones de la matriz en un solo paso temporal. A diferencia de la electrónica tradicional, que suele funcionar en la gama de bajos GHz, las velocidades de modulación óptica pueden lograrse con velocidades de hasta la gama de 50 a 100 GHz". Esto significa que el proceso permite velocidades de datos y densidades de computación, es decir, operaciones por área de procesador, nunca antes alcanzadas.

Los resultados tienen una amplia gama de aplicaciones. En el campo de la inteligencia artificial, por ejemplo, se pueden procesar más datos simultáneamente, ahorrando energía. El uso de redes neuronales más grandes permite hacer pronósticos más precisos, y hasta ahora inalcanzables, y un análisis de datos más exacto. Por ejemplo, los procesadores fotónicos permiten evaluar grandes cantidades de datos en los diagnósticos médicos, por ejemplo, en los datos tridimensionales de alta resolución producidos con métodos especiales de diagnóstico por imágenes. Otras aplicaciones se encuentran en los ámbitos de los vehículos automotores, que dependen de una evaluación rápida y veloz de los datos de los sensores, y de infraestructuras de tecnología de la información como la computación en nube, que proporcionan espacio de almacenamiento, potencia de cálculo o software de aplicaciones.

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.

Publicación original

Johannes Feldmann, Nathan Youngblood, Maxim Karpov, Helge Gehring, Xuan Li, Maik Stappers, Manuel Le Gallo, Xin Fu, Anton Lukashchuk, Arslan Raja, Junqiu Liu, David Wright, Abu Sebastian, Tobias Kippenberg, Wolfram Pernice, and Harish Bhaskaran; "Parallel convolution processing using an integrated photonic tensor core"; Nature; 2021